當一部電腦處理龐大資料時,它會需要多少時間?

以目前由IBM開發的最快超級電腦--藍色基因來說

它每秒能處理 280.6 T 的浮點運算(1T=2^40=1,024*1,024*1,024*1,024=1,099,511,627,776)

它得開發成本為 2百萬美元

比起以前大型超級電腦成本算是少很多

為什麼?

因為它使用了分散式運算

就由很多台機器串連

以降低成本

但是

成本仍嫌貴

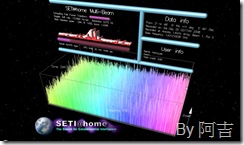

自1999年五月有項計畫開始運作

計畫原名為

SETI (Search for Extraterrestrial Intelligence)

中譯:搜尋地外文明計劃

有人會說這是幹嘛的?

顧名思義它就是透過雷達搜尋外星人

24小時接收並記錄由太空所發設的信號

那有什麼特別?

這項計畫特別之處是在於

它將所觀測的電波資料拆解成許多部分

並將資料發送出去給有興趣的人下載並且分析

因為資料太過龐大

透過單一的超級電腦不知道要運算到何時?

所以計畫的負責人將資料拆解

發送至全球各地的電腦分析

分析完成的結果上傳至集中伺服器以便專業人士解讀

目前Seti@home的運算能力為每秒鐘72.53T的浮點運算能力

這項計畫成本多少?

目前不曉得

但是能確定的是

成本會比單一的超級電腦小很多

因為它只是透過一般電腦使用者分享一點點的效能

當許多部電腦累積時

自然運算能力大幅提升

除了這個以外

還有另一項很有名的計畫

Folding@home

這個計畫為計算蛋白質的摺疊、誤折、聚合所引發的相關疾病

目的在於了解一些特殊疾病(像是阿茲海默症、癌症等等)的起因

並找出解決之道

在2007之前這項計畫的處理速度只有每秒處理195T浮點數

在開發出給PS3的程式後

PS3也加入計畫行列

拜PS3強大CPU之賜

目前計畫的速度來到了每秒處理0.7P浮點數(1P=2^50=1,024*1,024*1,024*1,024*1,024=1,125,899,906,842,624)

比T在大一個單位

以上這些計畫只是一小部分而已

事實上仍然還有許多種計畫

我目前還有加入Einstein@home

於2005年(世界物理年)的這一年開始的計畫

目的是要找出脈衝星的重力波以驗證愛因斯坦的相對論預測

LHC@home

因為對撞機還沒對撞

所以目前沒有任何資料可分析

當我們使用電腦時

不一定只是拿來打GAME

或是上網

電腦仍然可以做很多事情

當我們電腦閒置時

CPU的處理能力可以拿去做其它事

如果只是掛在那邊

哪豈不就是在浪費電力了嗎?

補充資料:

wiki上的訊息(點擊瀏覽)

Seti@home

Folding@home

Einstein@home

LHC@home

雲端運算

超級電腦

分散式計算

沒有留言:

張貼留言